Bessere Positionierung in Suchmaschinen

Was nutzt es, viele Informationen auf einer Webseite darzustellen, wenn niemand sie findet? Wohl nicht all zu viel. Auch wenn die Crawler (Bots, die das Netz nach Inhalten durchsuchen) Ihre Seite finden und indizieren, so müssen – um in den Suchergebnissen weit oben gelistet zu werden – einige Voraussetzungen erfüllt werden. Die sog. SEO (Search Engine Optimization) hat genau dies zum Ziel.

Wir gehen hier näher auf Google ein, da es sich um die mit Abstand meistgenutzte Suchmaschine handelt. Natürlich gibt es auch andere, wie z.B. Yahoo oder DuckDuckGo.

Design- und Inhaltsrichtlinien

Suchmaschinenalgorithmen prüfen verschiedene Eigenschaften der Webseite. Zum Beispiel die Übereinstimmung von Überschriften und Texten der Seite. Im Inhalt der Seite sollte der URL (Unified Resource Locator, also z.B. www.netzwerkstudio.de) wiederzufinden sein. Je häufiger, desto besser.

Erstellen Sie eine Website mit klar strukturiertem Aufbau und Textlinks. Jede Seite sollte über mindestens einen statischen Textlink erreichbar sein.

Stellen Sie den Nutzern eine Sitemap mit Links zu den wichtigen Teilen Ihrer Website zur Verfügung. Falls die Sitemap sehr viele Links enthält, empfiehlt es sich, die Sitemap in mehrere Seiten zu unterteilen.

Beschränken Sie die Anzahl der auf einer Seite vorhandenen Links auf ein vernünftiges Maß.

Erstellen Sie eine nützliche, informative Website und verfassen Sie Seiten, die Ihren Inhalt klar und eindeutig beschreiben.

Überlegen Sie sich, welche Suchbegriffe Nutzer eingeben könnten, um nach Ihren Seiten zu suchen, und verwenden Sie diese Begriffe auf Ihrer Website.

Verwenden Sie zur Anzeige wichtiger Namen und Links oder wichtiger Inhalte keine Bilder, sondern Text. In Bildern enthaltener Text wird vom Google-Crawler nicht erkannt. Wenn Sie Bilder für Textinhalte verwenden müssen, fügen Sie mithilfe des Attributs ALT beschreibenden Text hinzu.

Stellen Sie sicher, dass die <title>-Elemente und ALT-Attribute aussagekräftig und eindeutig sind.

Überprüfen Sie Ihre Seiten auf fehlerhafte Links und sorgen Sie für eine korrekte Verwendung der HTML-Syntax.

Beachten Sie bei Verwendung dynamischer Seiten (beispielsweise bei Seiten, deren URL ein Fragezeichen „?“ enthält), dass nicht jeder Crawler sowohl dynamische als auch statische Seiten durchsucht. Verwenden Sie wenige und kurze Parameter.

Technische Richtlinien

Damit Google die Inhalte Ihrer Website vollständig interpretieren kann, lassen Sie zu, dass alle Assets Ihrer Website, wie CSS- und JavaScript-Dateien, gecrawlt werden. Durch das Indexierungssystem von Google werden Webseiten unter Verwendung des HTML-Codes einer Seite sowie mithilfe der entsprechenden Assets wie beispielsweise Bilder, CSS und JavaScript-Dateien gerendert. Um sich die Seiten-Assets anzusehen, die nicht von Googlebot gecrawlt werden können, und um Fehler in den Anweisungen in Ihrer Datei „robots.txt“ zu beheben, verwenden Sie die Tools Abruf wie durch Google und robots.txt-Tester in der Search Console.

Ermöglichen Sie Suchrobots, Ihre Website ohne Sitzungs-IDs oder Parameter zu crawlen, die ihren Weg durch die Website aufzeichnen. Diese Methoden sind hilfreich, um die Aktivitäten einzelner Nutzer zu analysieren. Das Zugriffsmuster von Suchrobots gestaltet sich jedoch vollkommen anders. Das Verwenden solcher Techniken kann zu einer unvollständigen Indexierung Ihrer Website führen, da Suchrobots eventuell keine URLs entfernen können, die unterschiedlich aussehen, aber auf dieselbe Seite verweisen.

Achten Sie darauf, dass Ihr Webserver den HTTP-Header „If-Modified-Since“ unterstützt. Über diese Funktion kann Ihr Webserver Google mitteilen, ob der Inhalt seit dem letzten Crawling Ihrer Website geändert wurde. Mit dieser Funktion können Sie Bandbreite und Overhead sparen.

Nutzen Sie die Datei „robots.txt“ auf Ihrem Webserver. Diese Datei teilt Crawlern mit, welche Verzeichnisse durchsucht werden dürfen und welche gesperrt sind. Vergewissern Sie sich, dass eine aktuelle Version der Datei für Ihre Website vorliegt, damit der Googlebot-Crawler nicht versehentlich blockiert wird. Die Datei „robots.txt“ kann mit dem robots.txt-Analysetool, das in der Google Search Console verfügbar ist, getestet werden, um die korrekte Verwendung der Datei sicherzustellen.

Ergreifen Sie angemessene Maßnahmen, um zu gewährleisten, dass sich Anzeigen nicht auf das Suchmaschinen-Ranking auswirken. Mit einer Datei „robots.txt“ kann beispielsweise verhindert werden, dass Google AdSense-Anzeigen und DoubleClick-Links gecrawlt werden.

Wenn Ihr Unternehmen ein Content-Management-System erwirbt, vergewissern Sie sich, dass das System Seiten und Links erstellt, die von Suchmaschinen gecrawlt werden können.

Mit der Datei „robots.txt“ können Sie das Crawlen von Suchergebnisseiten und anderen automatisch erstellten Seiten verhindern, die keinen wirklichen Wert für über eine Suchmaschine auf Ihre Website geleitete Nutzer haben.

Testen Sie Ihre Website, um sich zu vergewissern, dass sie in verschiedenen Browsern richtig dargestellt wird.

Überprüfen Sie die Leistung Ihrer Website und optimieren Sie Ladezeiten. Google möchte seinen Nutzern möglichst relevante Suchergebnisse und eine großartige Nutzererfahrung bieten. Schnelle Websites erhöhen die Zufriedenheit der Nutzer und verbessern die Gesamtqualität des Webs, insbesondere für Nutzer mit einer langsamen Internetverbindung. Wir hoffen, dass Webmaster durch die Verbesserung ihrer Websites auch zu einem insgesamt schnelleren Web beitragen.

SSL Verschlüsselung

SSL bietet verschlüsselte Verbindungen zwischen Server und Client mit Zertifikaten nach dem X.509 Standard und ermöglicht darüber hinaus die Sicherstellung der Nachrichtenintegrität. Dafür nutzt SSL das Public-Key-Verfahren. Dabei werden Daten mit einem öffentlich zugänglichen Schlüssel codiert und sind dann nur mit einem privaten Schlüssel wieder decodierbar.

Seit kurzer Zeit „belohnt“ Goolge solche Webseiten, die über eine SSL-Verschlüsselung verfügen, mit einem besseren Ranking. Obendrein bieten Sie Ihren Besuchern einen ordentlichen Schutz ihrer Privatsphäre. Dies wiederum schafft Vertrauen für Ihr Unternehmen. Eine Win-Win-Win Situation sozusagen.

Gezielte Werbung mit Google Adwords

Neben der organischen Suche, wie wir sie oben beschrieben haben, bietet Google auch kampagnengesteuerte Suchergebnisse an. Dies natürlich nur gegen Bezahlung.

Hier können Sie Kampagnen erstellen, in denen Sie Ihren Seiten entprechende Keywords (Schlüsselwörter) und sog. CPC (Cost per Click, dt. Kosten per Klick) zuordnen. Sucht nun jemand nach diesem Keyword und haben Sie noch Guthaben auf Ihrem Tagesbudget, wird Ihr AdWord-Snippet (also die Werbeanzeige) neben den organischen Suchergebnissen angezeigt.

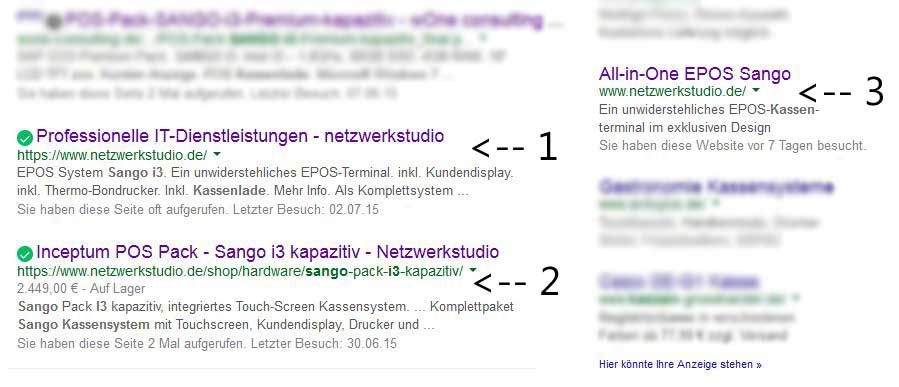

1) Organische Suche, durch Google Bot indiziert, Verweis auf unsere Startseite, da der Suchbegriff im Slider gefunden wurde. 2) Organische Suche, ebenfalls durch Google Bot indiziert, Verweis auf Shopartikel. 3) AdWords Kampagne, selbst erstellter Text mit selbst angegebenem Ziel-URL.

Klickt nun jemand auf Ihre AdWords Anzeige (3), so wird Ihnen dieser Klick vom Tagesbudget abgezogen. Die Darstellung selbst ist noch nicht kostenpflichtig! Die organischen Ergebnisse (1 und 2) verursachen natürlich keinerlei Kosten.

Auf welcher Seite Ihre Werbung in den Suchergebnissen angezeigt wird, hängt davon ab, wie viele andere über Ihrem CPC liegen. Das hört sich vielleicht kompliziert an, ist im Prinzip aber recht einfach.